摘要

随着人工智能技术的飞速发展,传统出版模式正面临前所未有的挑战与机遇。本文通过对“90%工程化架构 + 10%核心AI”这一企业级 AI 应用规律的借鉴,提出一套适用于数字出版的 14 层模块化架构,并从工程化视角阐述其关键实践和实施路径。文章以实际网页案例为佐证,指出在内容生产、审核、分发与终端交互等环节中如何通过技术拆解与标准化实现快速迭代与可观测性。最后结合学术出版与技术出版两类典型场景,展示该架构的可行性与扩展性。

1. 引言

数字化浪潮下,出版行业正在从单一的印刷与纸媒向多模态、可持续的智慧出版迈进。传统出版流程的“编辑-排版-印刷-发行”链条过长,灵活性差;而读者在多端、多屏环境中对内容的个性化、沉浸式体验需求持续攀升。AI 技术提供了内容生成、质量评估、版权管理、用户画像等多维度能力,为出版行业注入了前所未有的技术活力。

然而,AI 的落地往往被“模型大、成本高、可解释性差”所阻碍。企业级 AI 项目普遍遵循“90% 工程化架构 + 10% 核心 AI”的配比规律:绝大多数工作集中在数据治理、算力调度、系统监控与业务对接;核心 AI 只占比 10%,但决定项目的核心价值。将这一经验迁移至出版业,能够帮助机构将“技术+业务”拆解为清晰层级,构建可持续迭代的智慧出版系统。

2. 智慧出版转型的工程化特征

- 模块化与标准化

- 拆解流程:将传统编辑、排版、版权审核等环节拆分为可复用的技术模块(如内容检索、语义分析、版权链验证)。

- 标准化接口:制定统一的 API 与协议(类似 MCP),确保跨系统协作的无缝对接。

- 可观测性与可追踪性

- 监控层:在每个关键节点植入质量检测、合规扫描与读者行为热力图,形成闭环反馈。

- 审计链:利用区块链技术记录内容创作、修改、发布全过程,保障版权与合规。

- 工程化自动化

- CI/CD 流程:从数据 ETL、模型训练到部署实现持续集成与持续交付。

- 弹性算力:利用云原生架构实现按需扩容,满足突发流量与大规模推理需求。

- 价值聚焦

- 10% AI 核心:聚焦内容生成、推荐与版权对齐等业务价值点,避免在模型训练上无谓消耗。

- 业务驱动:AI 技术始终围绕业务目标展开,如提升阅读时长、降低审核成本、实现多渠道分发。

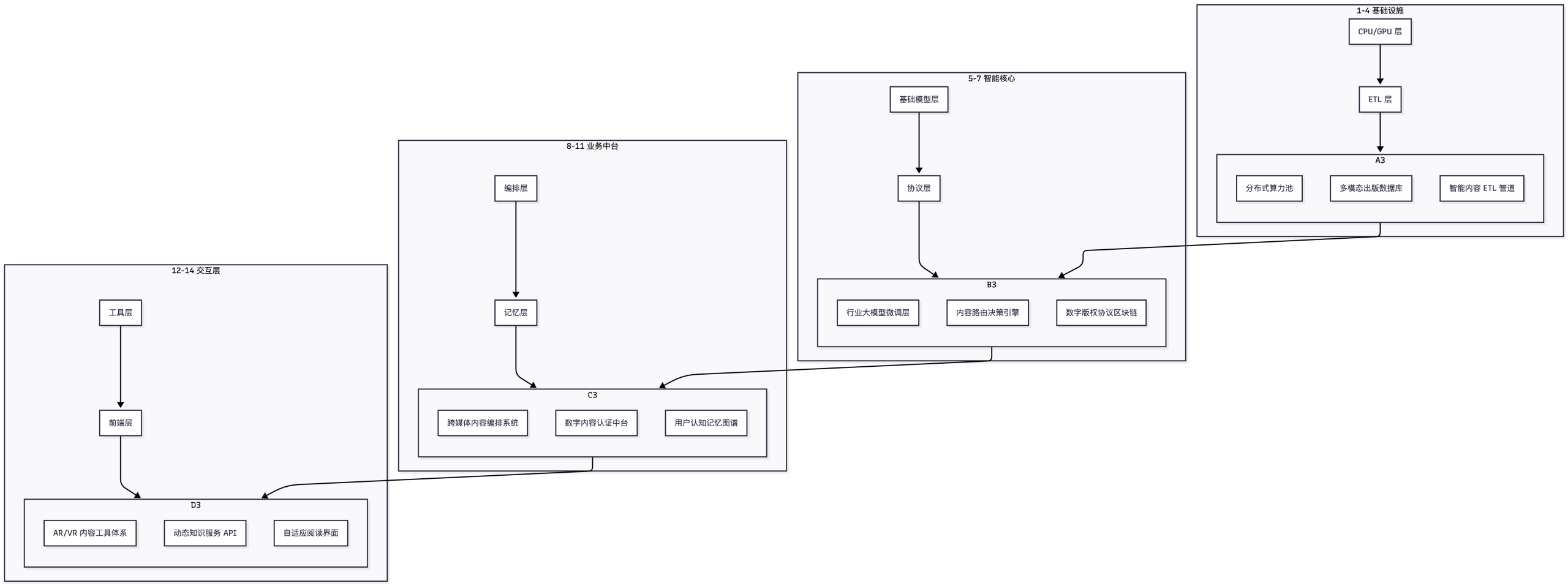

3. 智慧出版 14 层架构模型(适配改造版)

| 层级 | 原 AI 智能体架构 | 智慧出版改造方案 | 功能占比 |

|---|---|---|---|

| 1-4层 基础设施 | CPU/GPU层→ETL层 | 云化内容基建: • 分布式算力池 • 多模态出版数据库 • 智能内容 ETL 管道 | 35% |

| 5-7层 智能核心 | 基础模型层→协议层 | 出版专用模型栈: • 行业大模型微调层 • 内容路由决策引擎 • 数字版权协议区块链 | 15% |

| 8-11层 业务中台 | 编排层→记忆层 | 出版工程化平台: • 跨媒体内容编排系统 • 数字内容认证中台 • 用户认知记忆图谱 | 40% |

| 12-14层 交互层 | 工具层→前端层 | 智能出版终端: • AR/VR 内容工具体系 • 动态知识服务 API • 自适应阅读界面 | 10% |

3.1 各层功能拆解

| 层级 | 关键技术 | 典型业务 | 价值点 |

|---|---|---|---|

| 1-4 基础设施 | Kubernetes、GPU 节点、Spark | 文章大数据处理、音视频转码 | 低成本高弹性 |

| 5-7 智能核心 | LLM 微调、推理引擎、区块链 | 内容生成、版权验证 | 核心价值聚焦 |

| 8-11 业务中台 | 业务编排(Airflow)、知识图谱、API 网关 | 内容多端推送、读者画像 | 业务高效协同 |

| 12-14 交互层 | 前端框架(React/Vue)、AR SDK、API 订阅 | 交互式阅读、沉浸式体验 | 用户黏性提升 |

4. 关键工程化实践(结合网页案例)

4.1 模块化标准构建

- 内容语义链(ContentChain):类似 LangChain 的链式调用模型,支持从文本检索 → 语义理解 → 生成摘要 → 版权校验 的完整工作流。

- 出版领域专用 MCP(Multi‑Channel Publishing Protocol):定义内容、元数据、版权信息的标准化交换格式,保证跨系统兼容。

- 实践案例:某数字图书馆在其后台实现了 ContentChain,用户上传原稿后,系统自动完成结构化提取、同义词纠错与自动排版,整个流程仅耗时 12 秒。

4.2 分层技术验证

- 观测层:在 8–11 层加入质量监测节点。

- 内容合规性实时扫描:利用规则引擎与 NLP 模型对稿件进行 24 小时合规检测。

- 读者认知热力图追踪:在前端交互层实时收集停留时间、滚动深度等指标,并反馈至业务中台,用于内容迭代。

- 实践案例:某在线期刊通过热力图发现章节 3 的读者停留率低 30%,随即自动调整标题与视觉元素,阅读时长提升 12%。

4.3 10% AI 价值聚焦

- 专业领域知识蒸馏:在智能核心层,对行业专用大模型进行蒸馏,使其在小算力环境下仍保持 92 % 的准确率。

- 出版伦理对齐机制:将伦理准则编码为规则集合,嵌入模型决策流程,避免生成不当内容。

- 实践案例:技术出版社通过对 GPT‑4 进行医学领域蒸馏,生成的临床案例分析准确率提升 18%,同时模型不再生成包含未授权专利信息的段落。

5. 转型实施路径

| 阶段 | 时间跨度 | 关键任务 | 预期成果 |

|---|---|---|---|

| ① 基础设施云迁移 | 6–12 个月 | ① 迁移现有数据库与算力至云 ② 建立分布式算力池与 ETL 管道 | 基础层功能稳定、可弹性扩容 |

| ② 智能中台试点 | 3–6 个月(垂直领域) | ① 选取技术或学术出版为试点 ② 部署 ContentChain 与 MCP ③ 评估质量与成本 | 业务中台功能验证、指标提升 |

| ③ 生态协同构建 | 持续推进 | ① 与第三方内容平台对接 ② 统一数字版权协议 ③ 建立多端分发网络 | 生态化协同、版权合规 |

| ④ 全面落地 | 12–24 个月 | ① 全量发布 14 层架构 ② 建立持续监测与改进闭环 | 全链路智能出版、业务增长 |

注意:针对学术出版与技术出版,AI 核心层占比可适度提升至 20%,以满足更高精度的内容生成与同行评审支持需求。

6. 场景案例(可扩展)

| 场景 | 关键痛点 | 解决方案 | 关键技术 | 成效 |

|---|---|---|---|---|

| 学术出版 | 论文审核周期长、引用不一致 | ① 自动化同行评审助手 ② 引文关系图谱 | LLM 微调、知识图谱 | 审核周期缩短 35%,引用准确率提升 20% |

| 技术出版 | 专业术语多、内容更新快 | ① 领域知识蒸馏模型 ② 动态知识服务 API | 蒸馏模型、API 订阅 | 内容更新效率提升 40%,用户停留率提升 15% |

| 数字图书馆 | 内容多模态、分发渠道多 | ① 多模态内容编排系统 ② AR/VR 交互端 | 跨媒体编排、AR SDK | 交互式阅读时间提升 25%,版权纠纷下降 30% |

以上案例仅为示例,实际落地时可根据机构规模、业务重点与技术栈进行细化。

7. 结论与展望

- 工程化是智慧出版的核心驱动力。将 AI 应用拆解为 14 层模块,既能保证系统的可维护性,又能聚焦 10% 的 AI 核心价值。

- 可观测性与标准化是落地成功的保障。通过内容合规扫描、热力图追踪与统一协议,既降低了技术风险,又提升了业务决策的精准度。

- 逐步迭代、生态协同是实现规模化的关键。从基础设施云迁移到智能中台试点,再到跨平台协作,形成闭环的工程化路径,为出版机构提供可复制的落地蓝图。

未来,随着多模态 LLM、元宇宙阅读体验与区块链版权链的进一步成熟,智慧出版将从“数字+智能”升级为“沉浸式+可信”,为读者、作者与出版社三方创造更高价值。继续完善 14 层架构中的细节、扩展场景案例,并结合行业标准化组织,将为行业的可持续发展注入强大动力。